技术路线

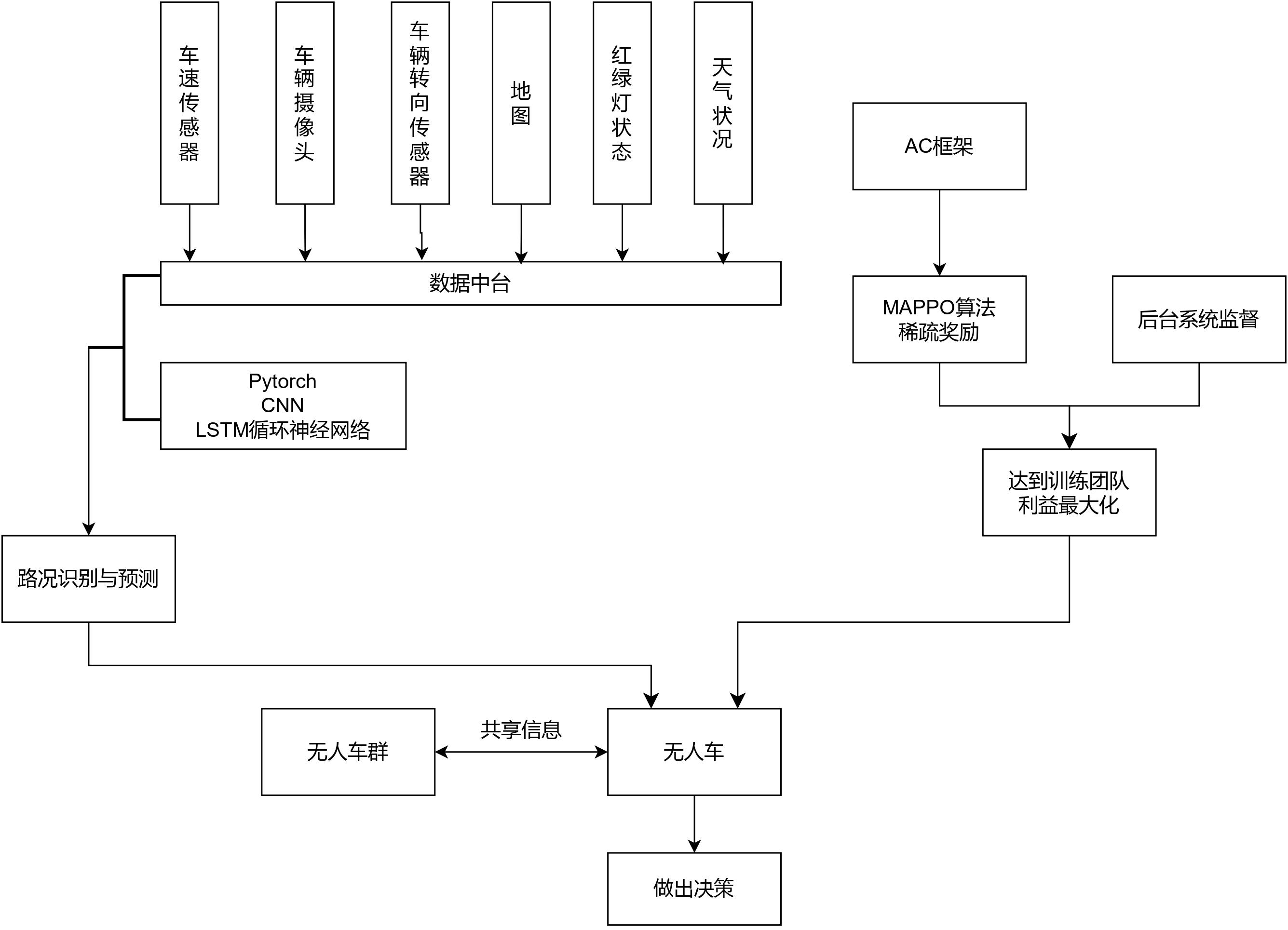

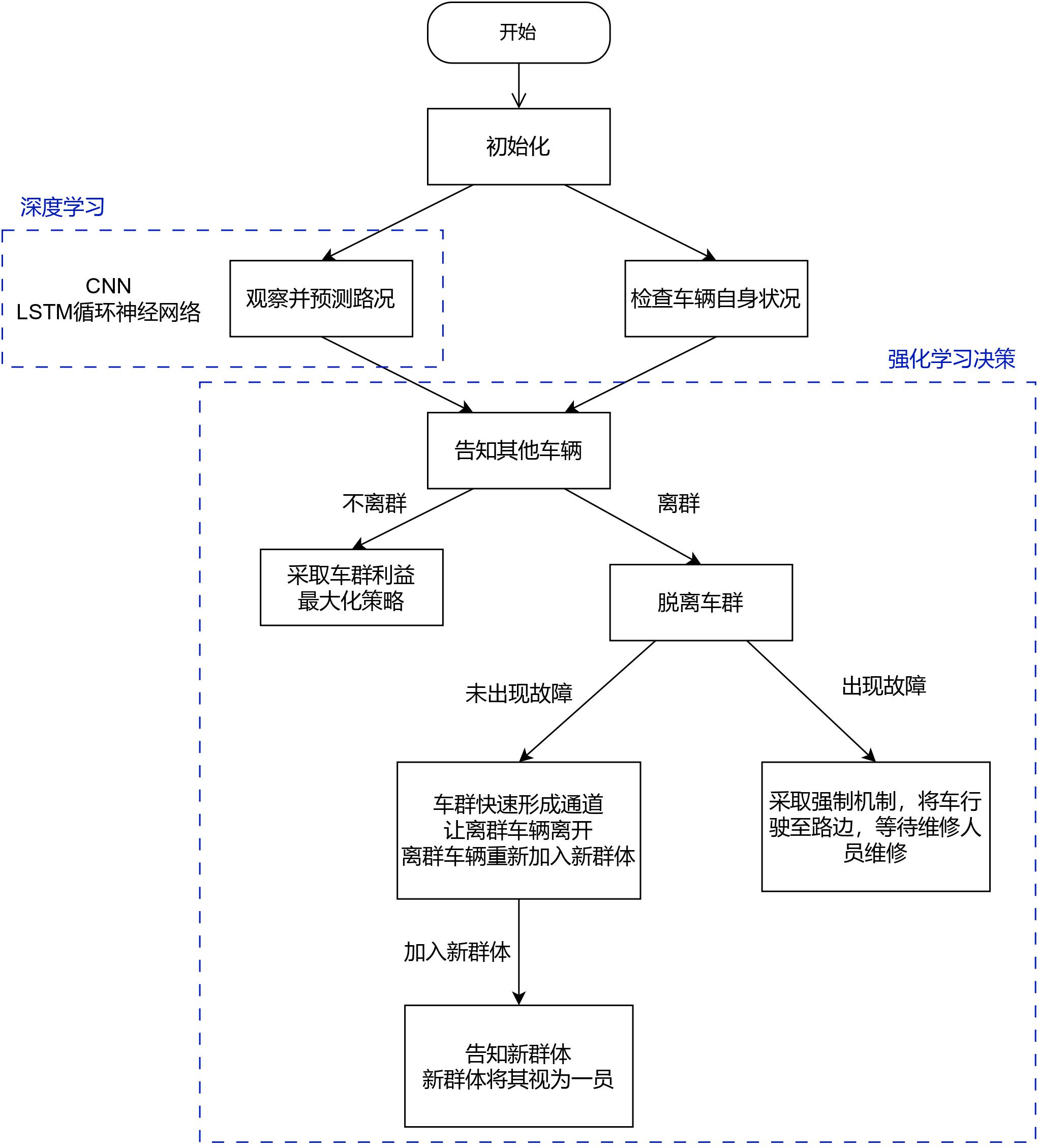

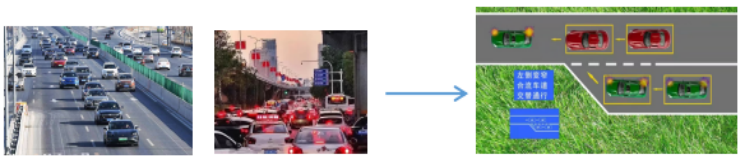

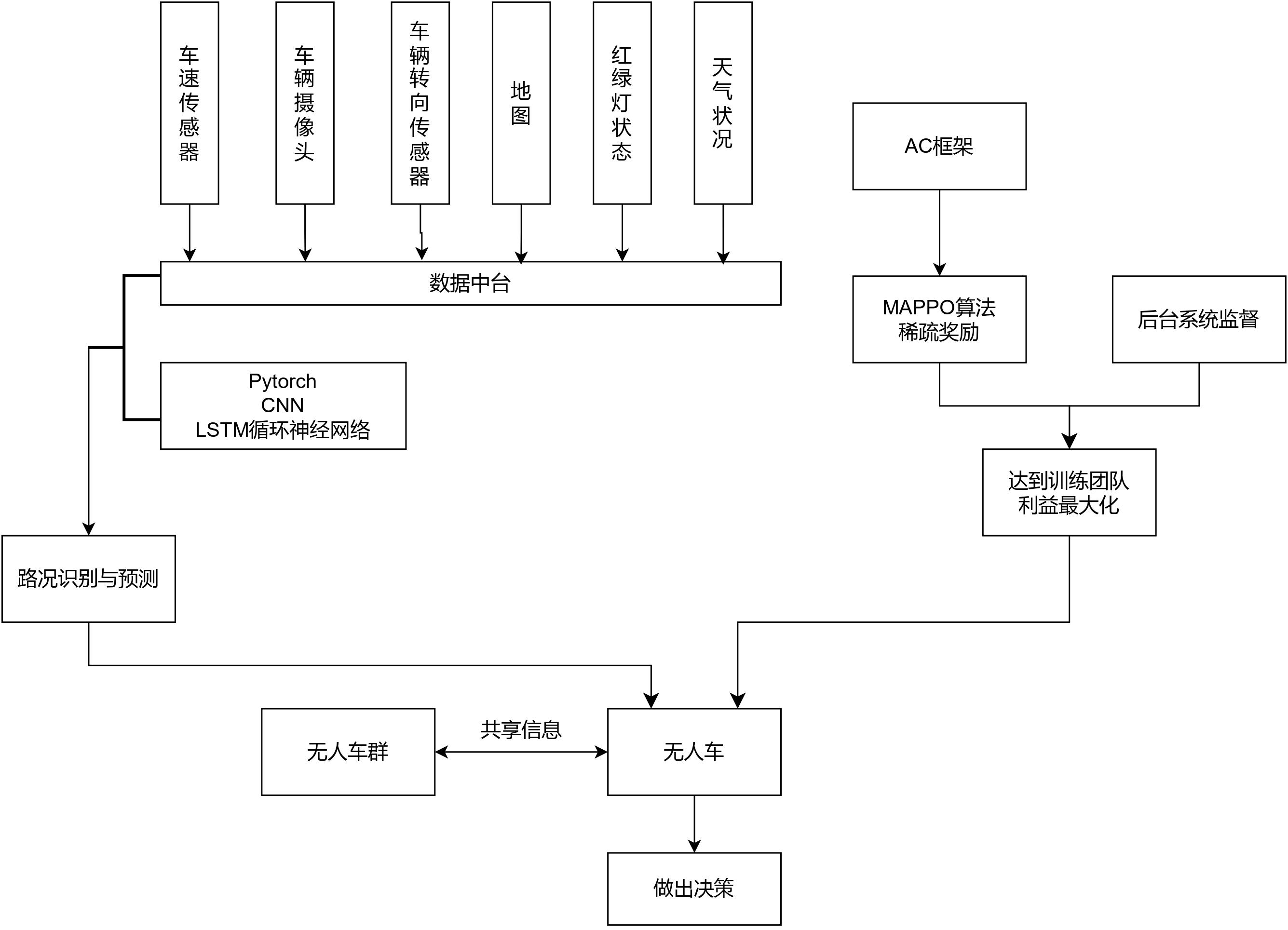

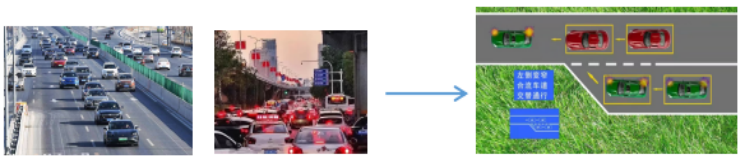

深度强化学习是将深度学习与强化学习相结合。它利用了深度学习进行数据特征提取,处理高维数据。强化学习进行决策控制、自我博弈。从而达到,大规模数据的分析处理与集群系统的智能决策与控制,如图2。

图2 输入与最终决策效果图

步骤一 利用深度学习提取天气,车辆数据,路况等环境信息

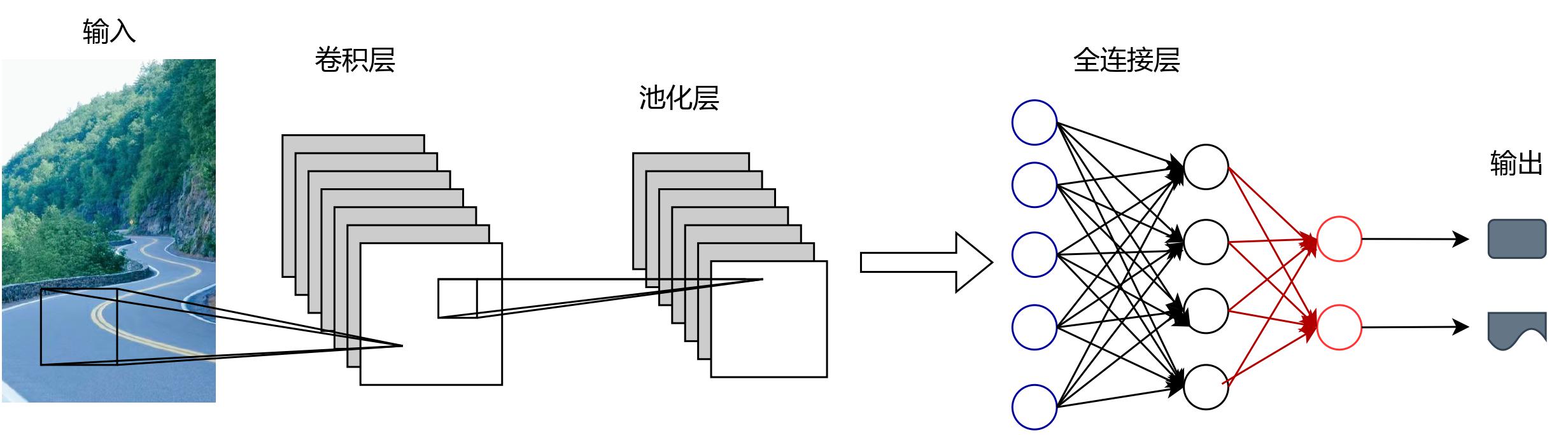

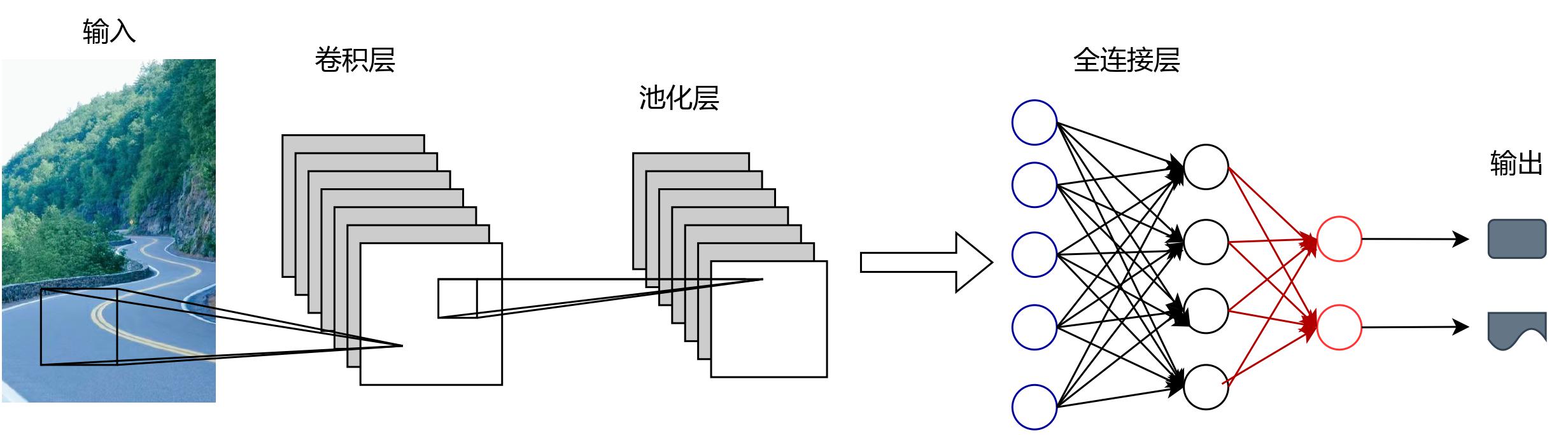

1.1采用CNN 卷积神经网络对图像数据进行处理,其中分为三层,如同3。

图3 卷积神经网络

图3 卷积神经网络

1.1.1输入层

将原始数据或其他算法预处理后的数据输入到卷积神经网络中。对于 n*n的黑白图片,CNN 的输入为二维神经元,对于 RGB 格式的图片,CNN 的输入为3*n*n的三维神经元。

1.1.2卷积层

通过卷积核的过滤提取出图片中局部的特征。拟采用以几个小滤波器卷积层

的组合进行操作。选择尺寸为3*3的小尺寸滤波器,并采用零填充,以确保不会

改变输入数据在空间维度上的尺寸和防止图片边缘信息过快损失。

1.1.3池化层

对图片进行降维,减少训练参数的数量,降低卷积层输出的特征向量的维度;保留最有效的图片信息,减少干扰的传递。

以下为拟采用的池化方法:

最大池化:对一个4×4特征图邻域内的值,用一个2×2的过滤器,步长为2进行扫描,将75%的激活数据丢弃,选择最大值输出到下一层。

1.1.4全连接层

处于卷积神经网络的尾部,以提取特征,进行分类。

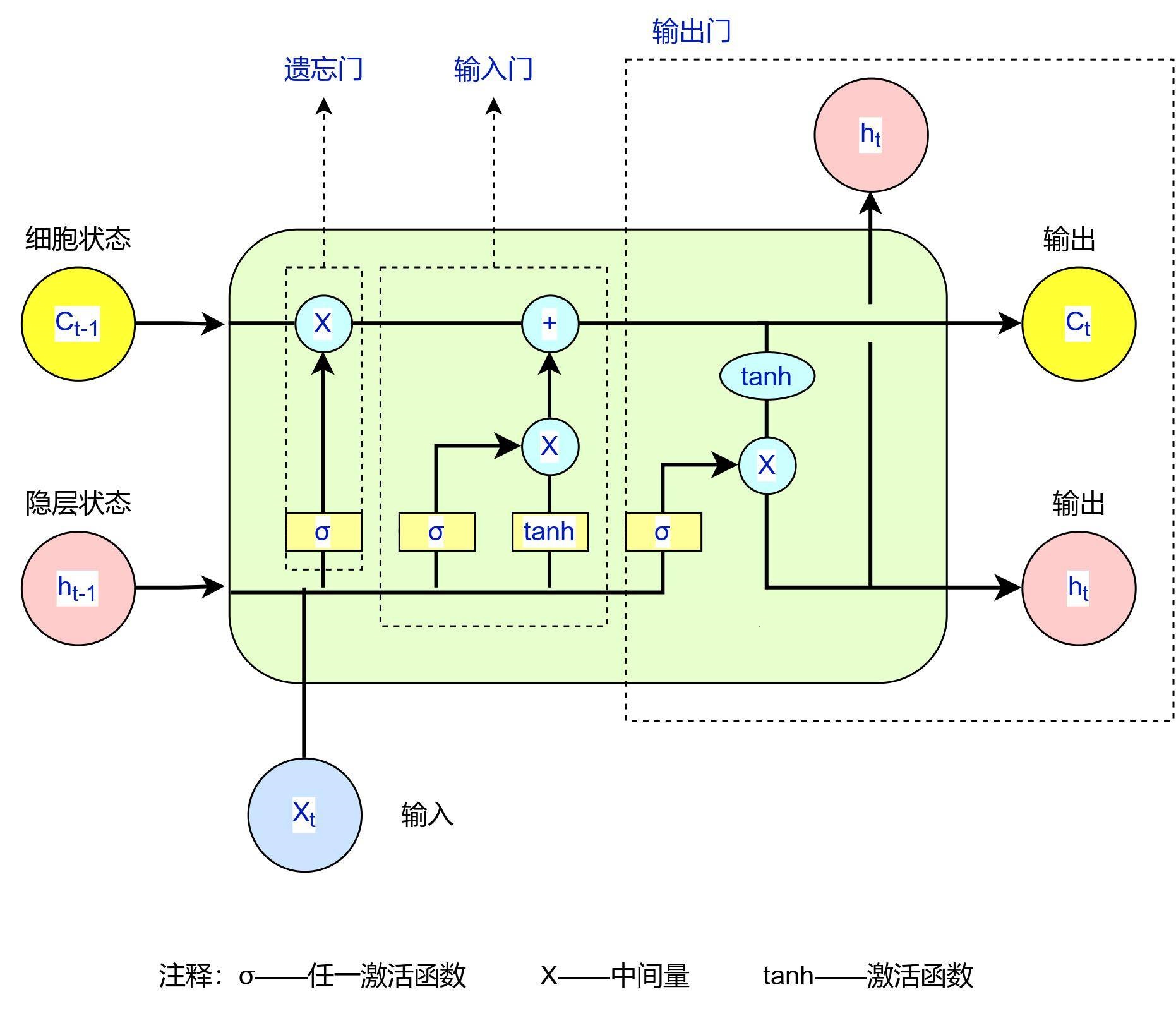

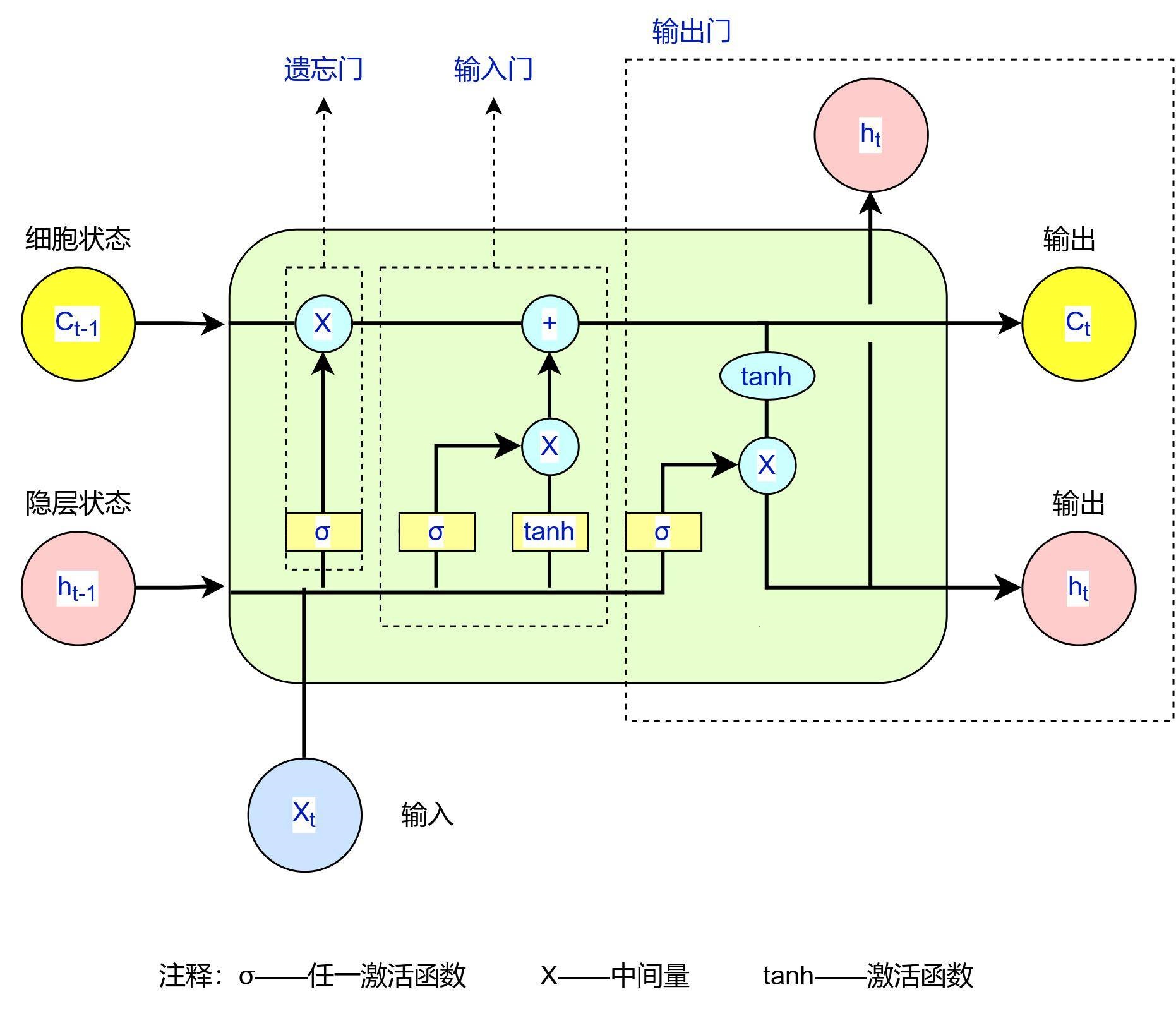

1.2 采用LSTM 循环神经网络对摄像头的视频和音频进行处理LSTM 中含有三种门,如图4。

图4 LSTM 循环神经网络

1.2.1输入门

决定当前时刻网络的输入有多少保存到单元状态。确保没有无关内容进入记忆。当前时刻的单元状态c_t的计算:由上一次的单元状态c_t-1按元素乘以遗忘门f_t,再用当前输入的单元状态 c_t 按元素乘以输入门i_t,再将两个积加和,从而把当前的记忆 c_t和长期的记忆c_t-1组合在一起,形成了新的单元状态c_t。

1.2.2输出门

控制单元状态有多少输出到 LSTM 的当前输出值,其控制了长期记忆对当前输出的影响,可以使用 tanh 作为激活函数。

1.2.3遗忘门

决定了上一时刻的单元状态有多少保留到当前时刻。

1.2.4对于每一项门,设置其权重矩阵和偏置项。使用 sigmoid 作为激活输入门和遗忘门的函数,sigmoid 函数值越接近于1,受到重视程度就越高;反之,越接近于0,受到程度就越低。根据受到的重视程度选择数据进行记忆。

步骤二 拟采用强化学习的 MAPPO 算法,训练车群之间的完全合作

1.3 MAPPO 算法

1.3.1 设置一个公用的奖惩机制,如表 1 所示;

表1 基于机器学习的无人驾驶车群的协调控制的奖惩机制

基于机器学习的无人驾驶车群的协调控制的奖惩机制 |

单元种类 | 奖惩 | 奖惩项目 | 奖惩值 | 奖惩备注 | 行为意图 |

单辆无人车单元 | 奖励 | 探测 奖励 | 5.0 | 若该辆无人驾驶汽车能及时发现异常无人车,其获得探测奖励。 | 鼓励单辆无人驾驶汽车实时感知周围环境、及时发现故障或失控无人车的行为 |

及时避让 奖励 | 7.0 | 若正常行驶的无人车能够及时避让异常无人车,不会与异常车发生碰撞,其获得及时避让奖励。 | 鼓励正常行驶的无人驾驶汽车及时避让故障或失控车的行为 |

惩罚 | 未及时探测 惩罚 | -5.0 | 若该辆无人驾驶汽车未能及时发现异常无人车,给予其未及时探测惩罚。 | 鼓励无人驾驶汽车实时感知周围环境的行为 |

未及时避让 惩罚 | -8.0 | 若正常行驶的无人车没有能够及时避让异常无人车,从而导致与异常车的碰撞,给予其未及时避让惩罚。 | 鼓励无人车及时采取措施避让故障车的行为 |

无人车群单元 | 奖励 | 及时变化阵型奖励 | 6.6 | 若无人车群中的一辆车或有人车突然发生故障或失控,车群将其视为障碍物,及时变化阵型,及时远离异常车,给予及时变化阵型奖励。 | 鼓励无人车群及时变化阵型的行为 |

实时调整间距奖励 | 6.0 | 若无人车群中的一辆车或有人车突然发生故障或失控,其余正常行驶的车辆应当使用合适的算法迅速增大与异常车的间距,以免与其碰撞,给予实时调整间距奖励。 | 鼓励无人车群依据实际情况实时调整车与车之间的间距的行为。 |

惩罚 | 未及时变化 阵型 惩罚 | -6.6 | 若无人车群中的一辆车或有人车突然发生故障或失控,车群没有将其视为障碍物,未及时变化车群的阵型,从而加大了与其碰撞的概率,给予其未及时变化阵型惩罚。 | 鼓励无人车群及时变化阵型的行为 |

未及时调 整间距 惩罚 | -6.0 | 若无人车群中的一辆车或有人车突然出现异常,其余正常行驶的车辆未能选用合适的算法增大与异常车的间距,从而加大了与其碰撞的概率,给予其未及时调整间距惩罚 | 鼓励无人车群实时调整车与车之间的间距的行为。 |

所有单元 | 惩罚 | 未及时感知 异常 惩罚 | -8.0 | 若无人车和有人车没有能够及时发现异常车辆,给予其未及时感知异常惩罚。 | 鼓励道路上所有车辆及时发现、感知出现异常车辆。 |

| 出界 惩罚 | -1.5 | 若有车辆突然跑出了我们预先划定的范围,给予其出界惩罚。 | 鼓励道路上所有车辆不跑出我们预先划定的界限 |

1.3.2 每个无人车都有其单独的 actor-critic 网络,当无人车对环境做出一个动作时,环境会给出相应的反馈给 actor 网络与 critic 网络,通过不断优化critic 网络,较好的拟合出动作价值函数,根据动作价值得到较优的车辆协同策略,来指导actor网络执行行为决策,actor网络依据环境给出的反馈和critic的打分情况进行下一步的操作;

1.3.3 选择混合式算法框架。训练初步阶段,无人车会将自身的状态观测数据传递给中心控制器,中心控制器得到全局状态后对模型进行训练,得到最优分散控制策略后传给智能体。训练结束后,智能体不再与中心控制器通信,可以基于自己的局部观测状态通过自己的动作策略函数来产生最优动作。

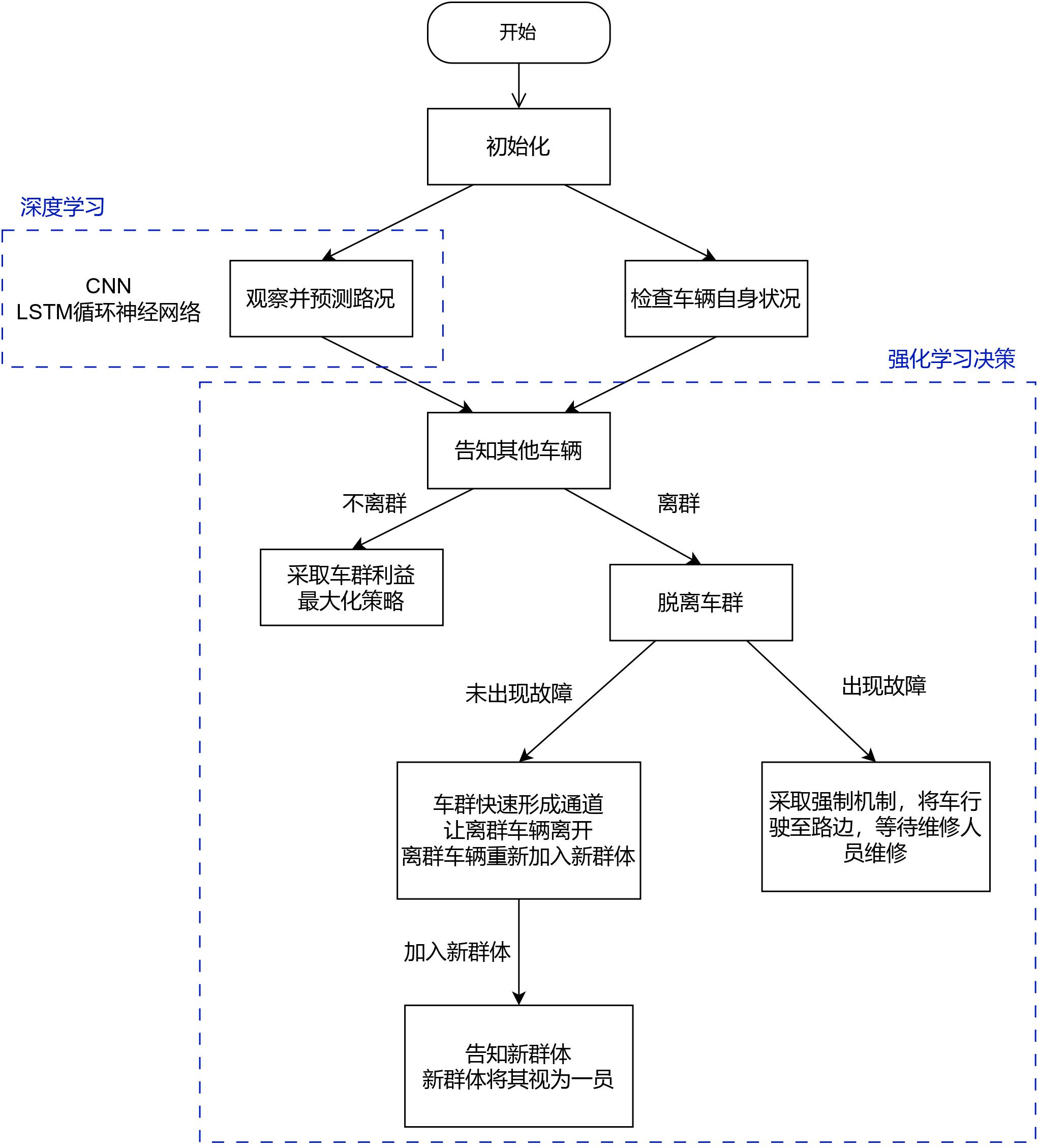

为了更加清晰的表示步骤一与步骤二的内容,计划书中将以图展示过程。以下为基于机器学习的无人车群协调技术的系统图与基于机器学习的无人车群协调技术的流程图,分别由图5和图6表示。

图5 基于机器学习的无人车群协调技术的系统图

图6 基于机器学习的无人车群协调技术的流程图

拟解决问题

拟解决主要通过车载传感器来实现无人驾驶车辆的自动控制成本高、容易出错,而且难以在恶劣环境下使用的问题。

预期成果

形成研究报告或发表省级论文1篇或软件著作权1项或申请专利1项。

大学生创新训练计划项目管理系统

大学生创新训练计划项目管理系统

图3 卷积神经网络

图3 卷积神经网络